Kinderen beter beschermd in iOS 15.2, geen kinderporno-scan

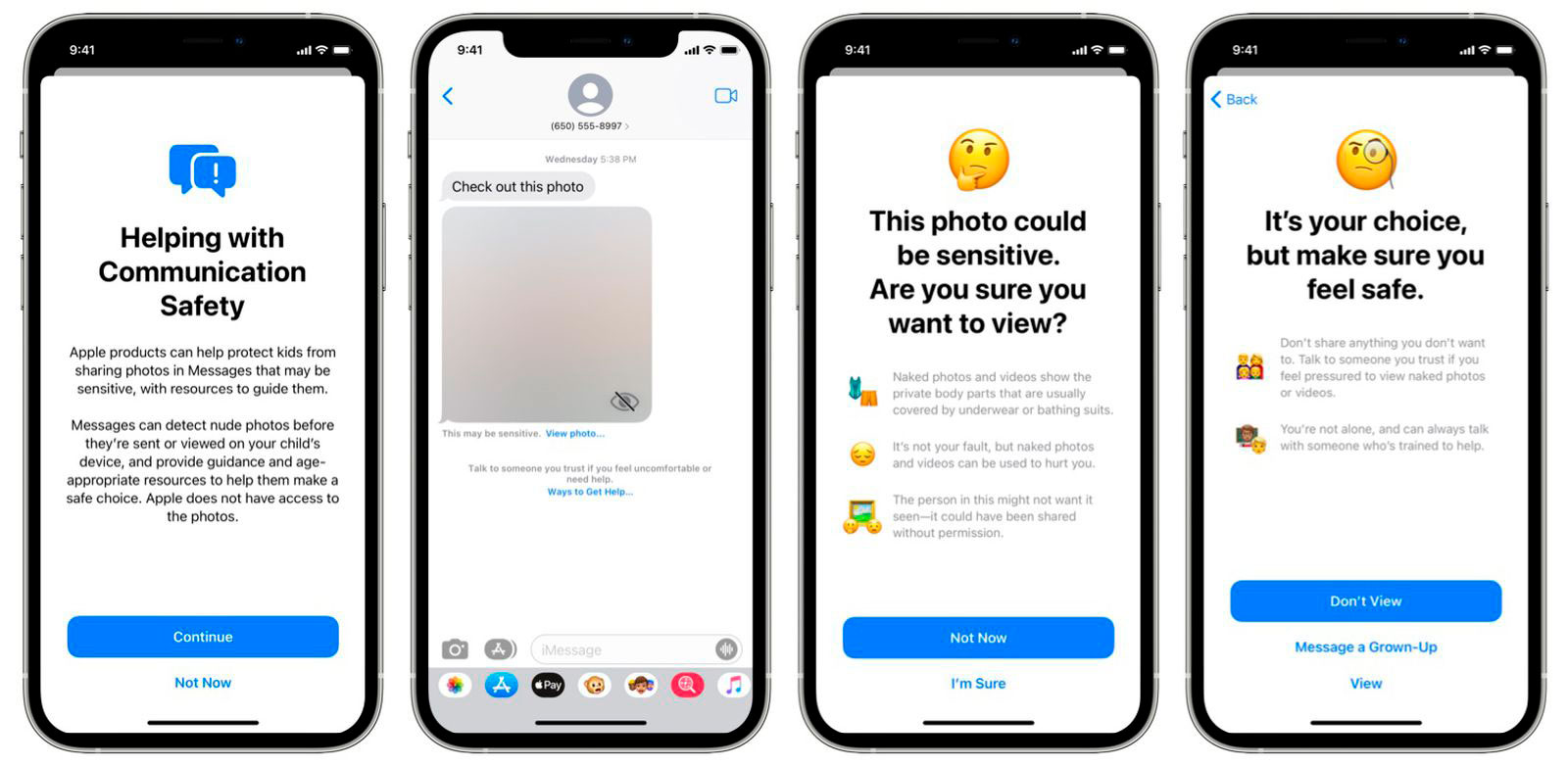

In de tweede beta-versie van iOS 15.2 vind je extra functies om kinderen te beschermen tegen ongewenste naaktbeelden, maar dit is niet de scan voor Child Sexual Abuse Material (CSAM), oftewel kinderporno, die eerder in het nieuws was. En deze nieuwe functie in iOS 15.2 staat standaard uit.

Bij Apple zouden ze trouwens ook nog steeds van plan zijn om

het scannen voor kinderporno uit te rollen, wanneer dat gaat gebeuren is niet bekend. Wat er nu in iOS 15.2 is ingebouwd is een onderdeel van

Delen met gezin, en wordt alleen actief als het door ouders wordt aangezet. Eenmaal aangezet kan de Berichten-app naaktbeelden herkennen die kinderen proberen te versturen of ontvangen.

Kinderen beter beschermd in iOS 15.2, geen kinderporno-scan

klik op de afbeeldingen voor een grotere versie

Bij het ontvangen wordt de foto automatisch onscherp gemaakt en krijgt het kind een link aangeboden met hulp hoe hiermee om te gaan. Daarbij is er ook een optie om de foto toch te bekijken (iets wat ieder nieuwsgierig kind waarschijnlijk zal doen).

Toen Apple in een eerdere fase kwam met dit soort opties was deze optie er ook al bij, maar daarbij was er een automatische notificatie voor de ouder(s) ingebouwd voor kinderen tot en met twaalf jaar. Daar kwam veel kritiek op, omdat het kinderen in situaties waarbij al sprake is van geweld of misbruik nog verder in gevaar kan brengen. Die optie is nu dus verwijderd, er worden geen notificaties meer verstuurd.

Het scannen voor naaktbeelden gebeurt op het device zelf, en heeft geen invloed op de versleuteling van de berichten. Er gaat ook geen data over het ontdekken van naaktbeelden het device uit, Apple heeft er ook geen toegang.

Kinderen beter beschermd in iOS 15.2, geen kinderporno-scan

#iOS