Steeds meer oppositie voor Apple’s plannen tegen kinderporno

Terwijl Apple op dit moment vooral bezig is

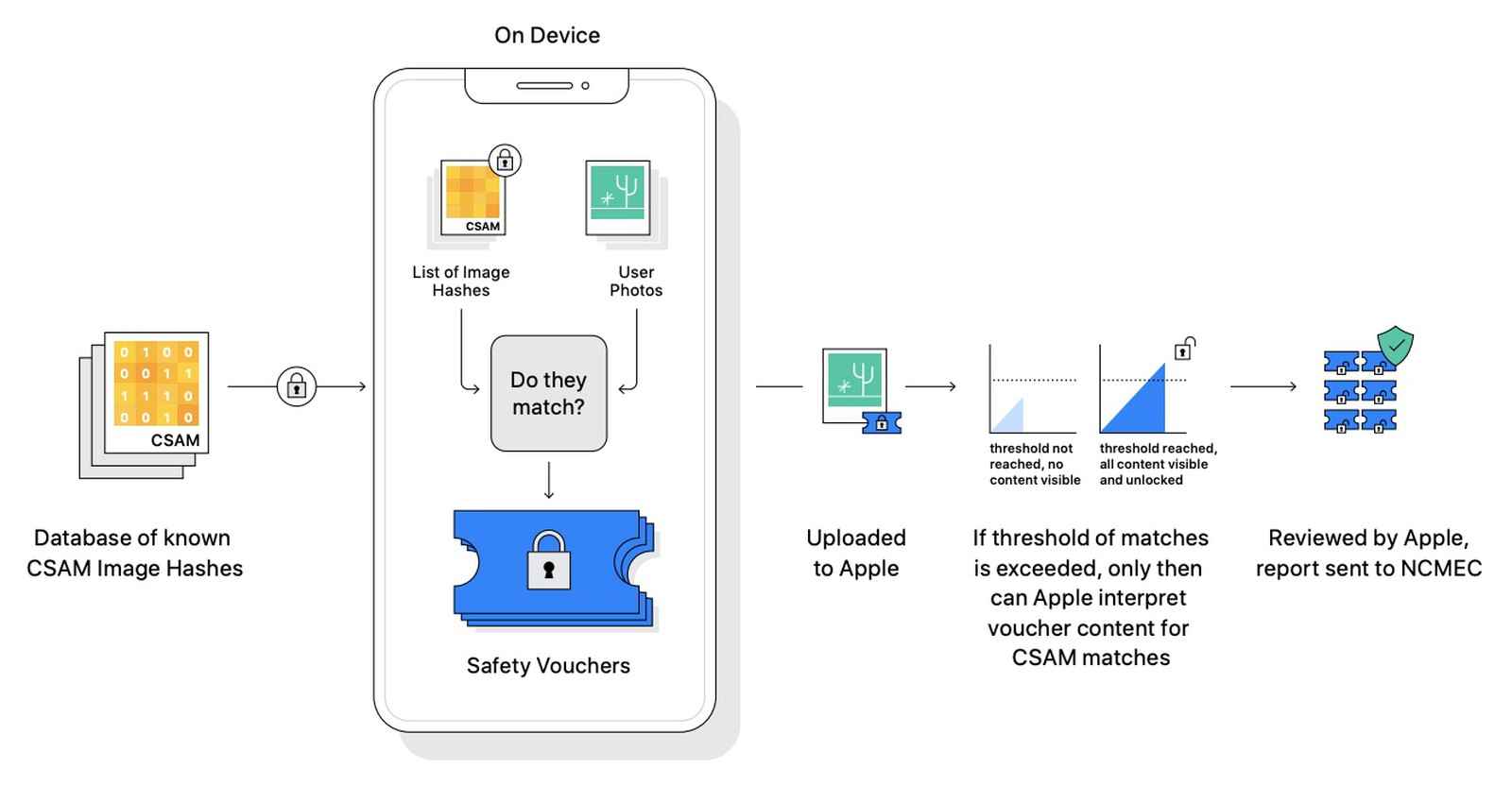

steeds beter uit te leggen hoe het scannen van Foto’s in iCloud op kinderporno in de VS binnenkort gaat werken, lijkt er alleen maar steeds meer tegenstand te ontstaan. En die tegenstanders spreken zich duidelijk uit.

Zo is de Electronic Frontier Foundation (EFF)

duidelijk tegen, roept het Center for Democracy & Technology (CDT) Apple op om helemaal

af te zien van deze plannen en heeft een lid van de Duitse Bundestag, Manuel Höferlin,

een brief aan Tim Cook geschreven met dezelfde strekking. Het laatste is vooral interessant omdat hij de voorzitter is van de Digitale Agenda-commissie van het Duitse parlement.

Steeds meer oppositie voor Apple’s plannen tegen kinderporno

klik op de afbeeldingen voor een grotere versie

Het meest interessant van de reacties die voorbij komen is waarschijnlijk die van Jonanath Mayer en Anunay Kulshrestha. De eerste is assistant professor of computer science and public affairs aan Princeton University, de tweede onderzoeker aan het Princeton University Center for Information Technology Policy.

Zij hebben samen een stuk geschreven wat in The Washington Post

is gepubliceerd en wat vooral interessant is omdat zij twee jaar geleden zelf een vergelijkbaar systeem gebouwd en getest hebben. Maar daarbij vonden ze een probleem wat anderen ook al gesignaleerd hebben:

We sought to explore a possible middle ground, where online services could identify harmful content while otherwise preserving end-to-end encryption. The concept was straightforward: If someone shared material that matched a database of known harmful content, the service would be alerted. If a person shared innocent content, the service would learn nothing. People couldn't read the database or learn whether content matched, since that information could reveal law enforcement methods and help criminals evade detection.

Knowledgeable observers argued a system like ours was far from feasible. After many false starts, we built a working prototype. But we encountered a glaring problem.

Steeds meer oppositie voor Apple’s plannen tegen kinderporno

Het probleem is dat wanneer zo’n systeem wordt gebruikt het niet denkbeeldig is dat overheden die graag de burgers beter willen surveilleren daar erg veel interesse in zullen hebben.

A foreign government could, for example, compel a service to out people sharing disfavored political speech. That's no hypothetical: WeChat, the popular Chinese messaging app, already uses content matching to identify dissident material. India enacted rules this year that could require pre-screening content critical of government policy. Russia recently fined Google, Facebook and Twitter for not removing pro-democracy protest materials.

We spotted other shortcomings. The content-matching process could have false positives, and malicious users could game the system to subject innocent users to scrutiny.

We were so disturbed that we took a step we hadn't seen before in computer science literature: We warned against our own system design, urging further research on how to mitigate the serious downsides…

Tot nu toe heeft Apple steeds gezegd dat ze dat nooit zullen toestaan. Maar Apple’s beleid is ook dat het altijd de wetten van een land waarin ze opereren volgt, dus wat belet zo’n land om een wet aan te nemen die een bedrijf als Apple verplicht om dit systeem ook voor die overheid bruikbaar te maken?

#Privacy #iOS